2023-03-31

2023-03-31

近日,计算机辅助设计国家地方联合工程实验室魏小鹏教授、尹宝才教授、张强教授、杨鑫教授团队的5项研究成果陆续被人工智能顶级会议/期刊(IEEE TPAMI、SIGGRAPH 2023、CVPR 2023、IEEE Robotics and Automation Letter)录用,其中1项研究成果被计算机视觉顶级期刊IEEE Transactions on Pattern Analysis and Machine Intelligence(TPAMI)录用,1项研究成果被2023年计算机图形学领域顶级会议(SIGGRAPH 2023)接收,2项研究成果被2023年计算机视觉与人工智能国际顶级会议(CVPR 2023)接收,1项研究成果被机器人知名期刊IEEE Robotics and Automation Letters(RA-L)录用。

IEEE TPAMI在中国计算机学会认定的人工智能领域四个A类期刊中排名第一,是计算机视觉及模式识别领域最顶尖的期刊,目前影响因子24.314。根据当前流行的Google Scholar Citation统计,IEEE TPAMI在所有计算机工程、电子工程及人工智能相关期刊榜单上以165分的h5-index排在第1位,主要收录人工智能、模式识别、计算机视觉及机器学习领域的原创性科研成果。TPAMI筛选极其严格,每年录用量仅200篇左右。

SIGGRAPH是世界上影响最广、规模最大,同时也是最权威的一个集科学、艺术、商业于一身的CG展示、学术研讨会,被中国计算机学会(CCF)列为A类会议。SIGGRAPH旨在促进计算机图形学、交互技术、虚拟现实、计算机动画、计算机游戏等领域的研究、教育和应用。SIGGRAPH筛选极其严格,每年录用量百余篇左右。

CVPR是计算机学科普遍认可的人工智能领域的顶级国际会议,被中国计算机学会(CCF)列为A类会议。根据当前流行的Google Scholar Citation统计,CVPR排在所有学科目录的第4位(Nature第1位,Science第3位,Cell第7位),排在电信学科所有期刊和会议的第1位。

IEEE Robotics and Automation Letters(RA-L)是机器人领域的权威期刊,该期刊收录的论文需较强的原创性,涵盖机器人技术、控制系统、传感器技术、计算机视觉、人机交互、生物医学工程等方面。

博士生张肇轩作为第一作者与博士生李童等人共同完成的研究成果“Point Cloud Scene Completion with Joint Color and Semantic Estimation from Single RGB-D Image”致力于解决从单张RGB-D图像中恢复出具有颜色和语义信息的三维场景模型的问题。针对单张图像所能提取信息有限的问题,提出了基于视角主动挖掘的场景渐进式补全方法,设计了平衡重建精度和视角数量的场景建模奖励函数,通过体素模型辅助充分挖掘当前视角内的环境信息,使用图像补全网络预测语义、颜色及深度图像中缺失区域信息,实现了精准的单视角室内场景三维点云建模,所重建出的场景模型可用于室内机器人自动导航及场景交互、虚拟/增强现实等领域。该工作被模式识别与机器智能顶刊IEEE TPAMI录用。

与其他单视角场景重建方法结果进行对比

硕士生张海薇作为第一作者与张吉庆、吴文玮等人共同完成的研究成果“In the Blink of an Eye: Event-based Emotion Recognition”是团队与普林斯顿大学合作完成的致力一项基于事件相机捕获眼动追踪信号的情绪识别方法。针对智能眼镜情绪识别系统在设备是否方便佩戴与采集信号、是否受光线影响、以及资源受限、如何实时响应等多重问题,提出了一套系统性的解决方案。首先构建了一个基于事件相机的眼动情感数据集,并提出了一种具备生物启发和生物可解释性的脉冲神经网络模型,该模型对表情的任意阶段进行建模,从而能够在任意时刻给出响应。网络设计在保证轻量化实时性的同时在准确度上达到了SOTA。同时将事件相机、头盔和嵌入式计算资源TX2进行了集成,搭建了智能眼镜原型机,在独立系统上实现了信号采集、数据传输、网络计算、反馈结果一体化流程。系统工作流程展示图如下图所示。该项工作未来将在更多新颖的应用上发挥作用:如有情感的数字人生成、VR/AR智能眼镜上的情感交互等,具有广阔的跟踪前景。该工作被计算机图形学顶会SIGGRAPH 2023录用。

网络结构图

博士生梅海洋作为第一作者完成的研究成果“Deep Polarization Reconstruction with PDAVIS Events”是团队与苏黎世联邦理工大学合作完成的一项关于新型神经形态视觉传感器(偏振事件相机)的研究。本工作首次利用偏振事件相机记录的偏振事件数据的低延迟、高动态范围、能够呈现物体内在物理特性而不受复杂环境影响的优点,重建出高质量(即高速、高动态范围)偏振视频。该研究能够为现有的计算机视觉任务提供新的、更加鲁棒的信息输入,能够帮助解决高速高动态范围等挑战性场景下的实际应用任务(如自动驾驶车辆在复杂场景中的行人/车辆检测),具备重要的研究意义与巨大的应用前景。本论文以较高的评审分数被人工智能与计算机视觉顶会CVPR 2023录用。

偏振事件相机(左)和偏振重建结果对比(右)

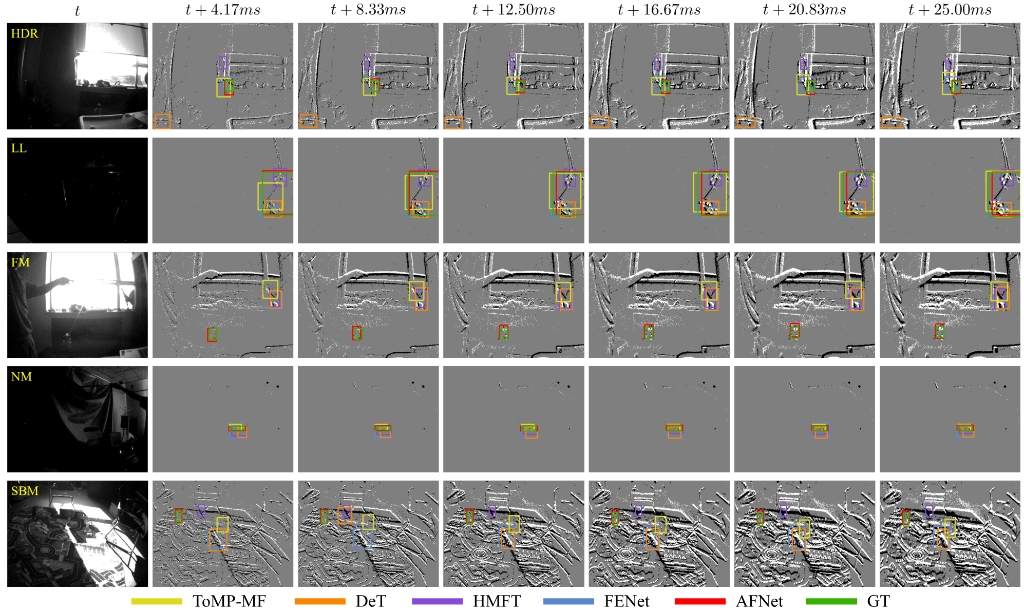

博士生张吉庆作为第一作者与硕士生王源琛等人共同完成的研究成果“Frame-Event Alignment and Fusion Network for High Frame Rate Tracking”致力于以多模态的角度解决高帧率目标跟踪问题。基于仿生形态事件相机的高时间分辨率优势,提出了跨模态对齐模块,同时完成跨风格对齐和跨帧率对齐,有效地在特征级别上将传统帧图像特征对齐至高帧率事件特征。本工作提出的算法在具有挑战场景下的目标跟踪精度优于现有算法,此项研究成果将有助于推动目标跟踪技术在开放环境下民用方面(移动机器人、智能交通系统)的使用。该工作被计算机视觉顶会CVPR 2023录用。

与其他目标跟踪方法结果进行对比

硕士生魏博言、叶贤丰等人共同完成的学术成果“Discriminative Active Learning for Robotic Grasping in Cluttered Scene”,提出了一种面向机器人抓取的判别式主动式学习策略,该策略利用一个共享特征编码与一个主动式学习判别器,从未标注数据池中选择出与已标注数据池中数据相似度最低的数据,并视其包含最多信息。经过多轮数据选择,判别式主动式学习策略将选出一个数据集的子集,机器人抓取姿态检测网络在这个子集上的训练效果可以达到在全部数据集上的训练效果,从而减少应用机器人抓取算法时数据标注的成本。该工作被IEEE Robotics and Automation Letters(RA-L)录用。

机器人抓取识别效果展示,输入为RGB-D图像,输出可视化为抓取矩形框

计算机辅助设计国家地方联合工程实验室,是国家发改委于2015年批复的国家级实验室。面向新一代人工智能,深入开展类脑智能、大数据智能、机器人智能、场景认知等相关基础理论与核心技术及工程应用研究。在智能计算、场景感知与建模、智能机器人等方面,取得了一批有国际影响力的研究成果。相关成果在工业产品设计、新闻播报、智能交通、智能机器人、安全监控、健康管理等领域得到实际应用,获得国家自然科学二等奖1项、国家科技进步二等奖2项、省部级科学技术一等奖13项、二等奖5项,获国际期刊、会议最佳论文奖10余项。

详细工作请参见主页:http://faculty.dlut.edu.cn/yangxin/zh_CN/index.htm和https://xinyangdut.github.io/

[1] Point Cloud Scene Completion with Joint Color and Semantic Estimation from Single RGB-D Image. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI) 2023.

[2]In the Blink of an Eye: Event-based Emotion Recognition. In ACM SIGGRAPH 2022 Conference Proceedings (SIGGRAPH) 2023.

[3]Deep Polarization Reconstruction with PDAVIS Events. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2023.

[4]Frame-Event Alignment and Fusion Network for High Frame Rate Tracking. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2023.

[5]Discriminative Active Learning for Robotic Grasping in Cluttered Scene.IEEE Robotics and Automation Letters(RA-L) 2023.

来源:电子信息与电气工程学部

编辑:郭栢辉

审核:于舒雯

最新动态

最新动态